传感器技术的显著进步使得获取同一场景的多模态图像成为可能。然而,受传感器成像机制和复杂地面环境的影响,单模图像往往不能提供足够详细的场景信息。例如,热红外图像包含来自物体的热辐射信号,因此在可见光谱之外提供了额外的信息,但纹理信息较弱。合成孔径雷达(SAR)图像具有丰富的地物极化信息,且不受云层覆盖的影响,但严重缺乏细节信息。与红外和SAR数据相比,可见光图像虽然提供了大量的纹理细节,但极易受到天气和光照变化的影响。因此,多模态图像融合对于同时弥补单模传感器的内容或细节不足,增强图像提供的信息具有重要意义。

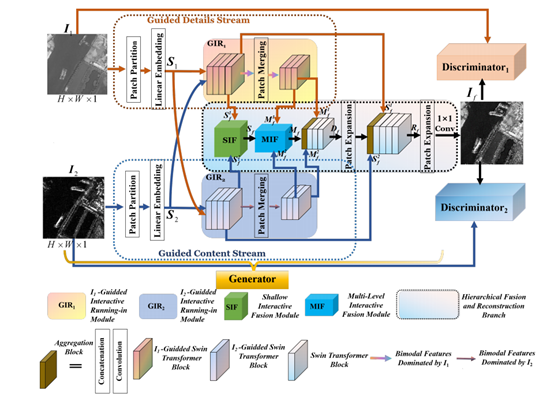

基于此,烟台大学隋晨红副教授的多模态遥感智能感知与认知团队设计开发了一种新的交互式引导生成对抗网络,称为IG-GAN,用于多模态图像融合任务。IG-GAN包括为增强细节和内容的学习以及跨模态一致性量身定制的引导双流。此外,为了使融合网络能够在没有监督的情况下生成内容完整、边缘锐利、保真度高的融合图像,还建立了一个损失函数,便于生成器和两个鉴别器之间相互博弈。结果表明,IG-GAN可以通过整合不同模态的互补信息来提高目标检测的精度。

相关工作以“IG-GAN: Interactive Guided Generative Adversarial Networks for Multimodal Image Fusion” 为题发表在期刊《IEEE Transactions on Geoscience and Remote Sensing》(影响因子8.2)上。该工作第一作者为隋晨红副教授,第二作者是物理与电子信息学院2020级硕士研究生杨国彬。该工作受到了国家重点研发计划项目、国家自然科学基金项目和中国博士后科学基金项目的资助。

审核:李营